Markov-processen werden in 1907 door wetenschappers ontwikkeld. Vooraanstaande wiskundigen uit die tijd ontwikkelden deze theorie, sommigen van hen zijn deze nog steeds aan het verbeteren. Dit systeem strekt zich ook uit tot andere wetenschappelijke gebieden. Praktische Markov-kettingen worden gebruikt in verschillende gebieden waar een persoon in een staat van verwachting moet aankomen. Maar om het systeem goed te begrijpen, moet je kennis hebben van de voorwaarden en bepalingen. Willekeur wordt beschouwd als de belangrijkste factor die het Markov-proces bepa alt. Toegegeven, het is niet vergelijkbaar met het concept van onzekerheid. Het heeft bepaalde voorwaarden en variabelen.

Kenmerken van de willekeurigheidsfactor

Deze toestand is onderhevig aan statische stabiliteit, meer bepaald de regelmatigheden ervan, waarmee geen rekening wordt gehouden in geval van onzekerheid. Op zijn beurt maakt dit criterium het gebruik van wiskundige methoden in de theorie van Markov-processen mogelijk, zoals opgemerkt door een wetenschapper die de dynamiek van waarschijnlijkheden heeft bestudeerd. Het werk dat hij maakte, ging rechtstreeks over deze variabelen. Op zijn beurt is het bestudeerde en ontwikkelde willekeurige proces, dat de concepten van staat enovergang, evenals gebruikt in stochastische en wiskundige problemen, terwijl deze modellen kunnen functioneren. Het biedt onder andere de mogelijkheid om andere belangrijke toegepaste theoretische en praktische wetenschappen te verbeteren:

- diffusietheorie;

- wachtrijtheorie;

- theorie van betrouwbaarheid en andere dingen;

- chemie;

- fysica;

- mechanica.

Essentiële kenmerken van een ongeplande factor

Dit Markov-proces wordt aangestuurd door een willekeurige functie, dat wil zeggen dat elke waarde van het argument wordt beschouwd als een bepaalde waarde of als een waarde die een vooraf voorbereide vorm aanneemt. Voorbeelden zijn:

- oscillaties in het circuit;

- bewegingssnelheid;

- oppervlakteruwheid in een bepaald gebied.

Er wordt ook algemeen aangenomen dat tijd een feit is van een willekeurige functie, dat wil zeggen dat indexering plaatsvindt. Een classificatie heeft de vorm van een toestand en een argument. Dit proces kan zowel met discrete als continue toestanden of tijd zijn. Bovendien zijn de gevallen verschillend: alles gebeurt in een of andere vorm, of tegelijkertijd.

Gedetailleerde analyse van het concept van willekeur

Het was best moeilijk om een wiskundig model te bouwen met de nodige prestatie-indicatoren in een duidelijk analytische vorm. In de toekomst werd het mogelijk om deze taak te realiseren, omdat er een willekeurig Markov-proces ontstond. Als we dit concept in detail analyseren, is het noodzakelijk om een bepaalde stelling af te leiden. Een Markov-proces is een fysiek systeem dat zijnpositie en toestand die niet voorgeprogrammeerd is. Het blijkt dus dat er een willekeurig proces in plaatsvindt. Bijvoorbeeld: een ruimtebaan en een schip dat erin wordt gelanceerd. Het resultaat is alleen bereikt vanwege enkele onnauwkeurigheden en aanpassingen, zonder welke de gespecificeerde modus niet is geïmplementeerd. De meeste lopende processen zijn inherent aan willekeur, onzekerheid.

Wat de verdiensten betreft, bijna elke optie die in overweging kan worden genomen, zal aan deze factor worden onderworpen. Een vliegtuig, een technisch apparaat, een eetkamer, een klok - dit alles is onderhevig aan willekeurige veranderingen. Bovendien is deze functie inherent aan elk lopend proces in de echte wereld. Zolang dit echter niet van toepassing is op individueel afgestemde parameters, worden de optredende storingen als deterministisch ervaren.

Het concept van een Markov stochastisch proces

Het ontwerpen van een technisch of mechanisch apparaat dwingt de maker om rekening te houden met verschillende factoren, met name onzekerheden. De berekening van willekeurige schommelingen en verstoringen ontstaat op het moment van persoonlijk belang, bijvoorbeeld bij het implementeren van een automatische piloot. Sommige van de processen die in de wetenschappen worden bestudeerd, zoals natuurkunde en mechanica, zijn.

Maar aandacht aan hen schenken en rigoureus onderzoek doen, moet beginnen op het moment dat het direct nodig is. Een willekeurig Markov-proces heeft de volgende definitie: de waarschijnlijkheidskarakteristiek van de toekomstige vorm hangt af van de toestand waarin het zich op een bepaald moment bevindt en heeft niets te maken met hoe het systeem eruitzag. zo gegevenhet concept geeft aan dat de uitkomst kan worden voorspeld, alleen rekening houdend met de waarschijnlijkheid en de achtergrond vergetend.

Gedetailleerde uitleg van het concept

Op dit moment bevindt het systeem zich in een bepaalde staat, het beweegt en verandert, het is in principe onmogelijk om te voorspellen wat er daarna zal gebeuren. Maar gezien de waarschijnlijkheid kunnen we zeggen dat het proces in een bepaalde vorm zal worden voltooid of de vorige zal behouden. Dat wil zeggen, de toekomst komt voort uit het heden en vergeet het verleden. Wanneer een systeem of proces in een nieuwe staat komt, wordt de historie meestal weggelaten. Waarschijnlijkheid speelt een belangrijke rol in Markov-processen.

De geigerteller toont bijvoorbeeld het aantal deeltjes, dat afhangt van een bepaalde indicator, en niet van het exacte moment waarop het kwam. Hier is het belangrijkste criterium het bovenstaande. In praktische toepassing kunnen niet alleen Markov-processen worden overwogen, maar ook soortgelijke, bijvoorbeeld: vliegtuigen nemen deel aan de strijd om het systeem, die elk worden aangegeven met een kleur. In dit geval is het belangrijkste criterium opnieuw de waarschijnlijkheid. Op welk punt het overwicht in aantallen zal optreden, en voor welke kleur, is onbekend. Dat wil zeggen, deze factor hangt af van de toestand van het systeem, en niet van de volgorde van de vliegtuigdoden.

Structurele analyse van processen

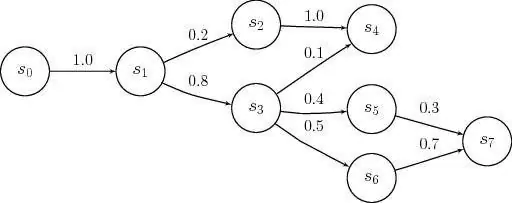

Een Markov-proces is elke toestand van een systeem zonder een waarschijnlijke consequentie en ongeacht de geschiedenis. Dat wil zeggen, als je de toekomst in het heden opneemt en het verleden weglaat. Oververzadiging van deze tijd met de prehistorie zal leiden tot multidimensionaliteit enzal complexe constructies van circuits weergeven. Daarom is het beter om deze systemen te bestuderen met eenvoudige schakelingen met minimale numerieke parameters. Als gevolg hiervan worden deze variabelen als bepalend beschouwd en door een aantal factoren bepaald.

Een voorbeeld van Markov-processen: een werkend technisch apparaat dat op dit moment in goede staat verkeert. In deze stand van zaken is van belang de waarschijnlijkheid dat het apparaat voor een langere periode zal functioneren. Maar als we de apparatuur als foutopsporing beschouwen, dan hoort deze optie niet langer bij het betreffende proces omdat er geen informatie is over hoe lang het apparaat eerder werkte en of er reparaties zijn uitgevoerd. Als deze twee tijdvariabelen echter worden aangevuld en in het systeem worden opgenomen, kan de toestand ervan worden toegeschreven aan Markov.

Beschrijving van discrete toestand en continuïteit van tijd

Markov-procesmodellen worden toegepast op het moment dat de prehistorie moet worden verwaarloosd. Voor onderzoek in de praktijk komen discrete, continue toestanden het vaakst voor. Voorbeelden van een dergelijke situatie zijn: de structuur van de apparatuur bevat knooppunten die tijdens werkuren kunnen uitvallen, en dit gebeurt als een ongeplande, willekeurige actie. Als gevolg hiervan ondergaat de toestand van het systeem reparatie van het ene of het andere element, op dit moment zal een van beide in orde zijn of zullen beide worden debugd, of omgekeerd, ze zijn volledig aangepast.

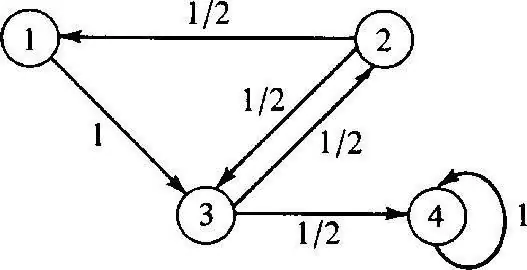

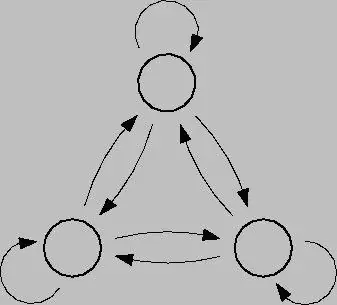

Het discrete Markov-proces is gebaseerd op kanstheorie en is ookovergang van het systeem van de ene toestand naar de andere. Bovendien treedt deze factor onmiddellijk op, zelfs als er onopzettelijke storingen en reparatiewerkzaamheden plaatsvinden. Om een dergelijk proces te analyseren, is het beter om toestandsgrafieken te gebruiken, dat wil zeggen geometrische diagrammen. Systeemstatussen worden in dit geval aangegeven door verschillende vormen: driehoeken, rechthoeken, stippen, pijlen.

Modelleren van dit proces

Discrete-state Markov-processen zijn mogelijke modificaties van systemen als gevolg van een onmiddellijke overgang, en die kunnen worden genummerd. U kunt bijvoorbeeld een toestandsgrafiek bouwen van pijlen voor knooppunten, waarbij elk het pad van verschillend gerichte faalfactoren, bedrijfstoestand, enz. zal aangeven. In de toekomst kunnen er vragen rijzen: zoals het feit dat niet alle geometrische elementen wijzen in de goede richting, want in het proces kan elk knooppunt verslechteren. Bij het werken is het belangrijk om sluitingen te overwegen.

Continu Markov-proces vindt plaats wanneer de gegevens niet vooraf zijn vastgelegd, het gebeurt willekeurig. Overgangen waren niet eerder gepland en vinden op elk moment plaats in sprongen. In dit geval wordt opnieuw de hoofdrol gespeeld door waarschijnlijkheid. Als de huidige situatie echter een van de bovenstaande is, is een wiskundig model nodig om deze te beschrijven, maar het is belangrijk om de theorie van de mogelijkheid te begrijpen.

Probabilistische theorieën

Deze theorieën beschouwen probabilistisch, met karakteristieke kenmerken zoalswillekeurige volgorde, beweging en factoren, wiskundige problemen, niet deterministisch, die zo nu en dan zeker zijn. Een gecontroleerd Markov-proces heeft en is gebaseerd op een kansfactor. Bovendien kan dit systeem in verschillende omstandigheden en met verschillende tijdsintervallen onmiddellijk naar elke toestand overschakelen.

Om deze theorie in de praktijk te brengen, is het noodzakelijk om een belangrijke kennis van waarschijnlijkheid en de toepassing ervan te hebben. In de meeste gevallen is men in een staat van verwachting, wat in algemene zin de theorie in kwestie is.

Voorbeelden van kansrekening

Voorbeelden van Markov-processen in deze situatie kunnen zijn:

- café;

- loketten;

- reparatiewerkplaatsen;

- stations voor verschillende doeleinden, enz.

In de regel hebben mensen dagelijks met dit systeem te maken, tegenwoordig heet het wachtrijen. Bij faciliteiten waar een dergelijke service aanwezig is, is het mogelijk om verschillende verzoeken te eisen, waaraan gaandeweg wordt voldaan.

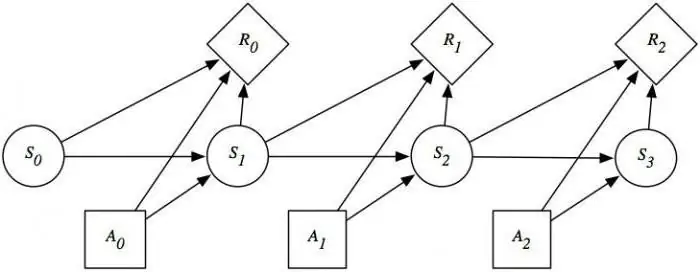

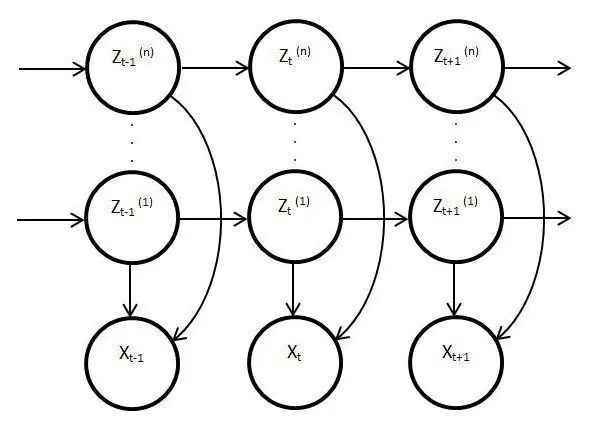

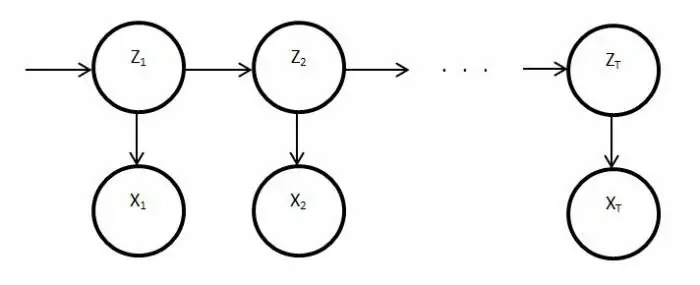

Verborgen procesmodellen

Dergelijke modellen zijn statisch en kopiëren het werk van het oorspronkelijke proces. In dit geval is het belangrijkste kenmerk de functie van het bewaken van onbekende parameters die moeten worden ontrafeld. Hierdoor kunnen deze elementen worden gebruikt bij analyse, oefening of om verschillende objecten te herkennen. Gewone Markov-processen zijn gebaseerd op zichtbare overgangen en op waarschijnlijkheid, alleen onbekenden worden waargenomen in het latente modelvariabelen beïnvloed door staat.

Essentiële onthulling van verborgen Markov-modellen

Het heeft ook een kansverdeling tussen andere waarden, waardoor de onderzoeker een reeks tekens en toestanden zal zien. Elke actie heeft een kansverdeling onder andere waarden, dus het latente model geeft informatie over de gegenereerde opeenvolgende toestanden. De eerste aantekeningen en verwijzingen ernaar verschenen eind jaren zestig van de vorige eeuw.

Toen werden ze gebruikt voor spraakherkenning en als analysers van biologische gegevens. Bovendien hebben latente modellen zich verspreid in schrift, bewegingen, informatica. Deze elementen imiteren ook het werk van het hoofdproces en blijven statisch, maar desondanks zijn er veel meer onderscheidende kenmerken. Dit feit betreft in het bijzonder directe observatie en sequentiegeneratie.

Stationair Markov-proces

Deze voorwaarde bestaat zowel voor een homogene overgangsfunctie als voor een stationaire verdeling, die als de belangrijkste en per definitie een willekeurige actie wordt beschouwd. De faseruimte voor dit proces is een eindige verzameling, maar in deze stand van zaken bestaat de initiële differentiatie altijd. Overgangskansen in dit proces worden beschouwd onder tijdscondities of aanvullende elementen.

Gedetailleerde studie van Markov-modellen en -processen onthult de kwestie van het bevredigen van het evenwicht op verschillende gebieden van het levenen activiteiten van de samenleving. Aangezien deze industrie de wetenschap en massadiensten beïnvloedt, kan de situatie worden gecorrigeerd door de uitkomst van gebeurtenissen of acties van dezelfde defecte horloges of apparatuur te analyseren en te voorspellen. Om de mogelijkheden van het Markov-proces volledig te gebruiken, is het de moeite waard om ze in detail te begrijpen. Dit apparaat heeft immers een brede toepassing gevonden, niet alleen in de wetenschap, maar ook in games. Dit systeem in zijn pure vorm wordt meestal niet overwogen, en als het wordt gebruikt, dan alleen op basis van de bovenstaande modellen en schema's.